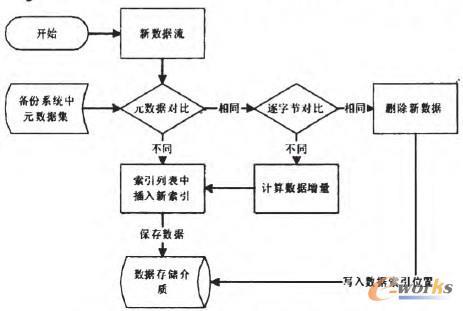

数据重复数据删除技术降低了备份所需的存储空间,而这实现了更快和更频繁的备份,从而有利于数据保护。还实现了更快的修复,在符合监管合规要求和公司政策的限制范围内尽可能延长数据保留时间。

重复数据删除技术可以影响实际的备份应用程序。

例如,由于重复数据删除数据保存在目标存储设备上,因此需要使用处理块存储的备份工具。

相比之下,基于文件存储的备份工具通常可以“撤销”所需的重复数据删除——导致目标存储设备上存放更多存储——除非备份工具只支持WindowsServer2012R2数据重复数据删除。

例如,像Windows服务器备份这样的工具完全支持重复数据删除,IT管理员可以从备份恢复一个完整的卷或个人文件夹。

记住,重复数据删除对系统、引导卷、远程驱动器、加密的文件或小于32KB的文件不起作用。其目的是备份和恢复任何常规文件。

重复数据删除定期运行所谓的垃圾回收来恢复不再使用的存储块。运行垃圾回收之后最好进行备份,确保捕获空闲存储器在备份过程中的任何变化。

数据重复数据删除技术改提高了存储效率,降低了存储成本并加快了数据保护的过程。

但重复数据删除技术的有效性和性能取决于工作负载和重复数据删除的设置。

IT管理员应该在应用重复数据删除之前和之后基准每个存储卷,以便衡量任何性能损失,因此应该调整调度和其他选项来优化服务器和工作负载性能。

备份和恢复过程也应提前进行测试以了解重复数据删除的数据的存储需求,并允许更新或补丁数据保护工具来提高用于数据备份的存储使用。

重复数据删除技术的优点包括哪些

备份设备中总是充斥着大量的冗余数据。

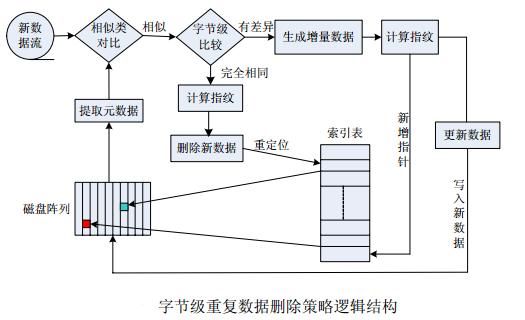

为了解决这个问题,节省更多空间,“重复删除”技术便顺理成章地成了人们关注的焦点。

采用“重复删除”技术可以将存储的数据缩减为原来的1/20,从而让出更多的备份空间,不仅可以使磁盘上的备份数据保存更长的时间,而且还可以节约离线存储时所需的大量的带宽。

就在几年前,D2D备份似乎还好得令人难以置信。

受价格低廉的ATA(以及稍后的SATA)硬盘的影响,很多人会选择用D2D取代虚拟磁带库或做备份到磁盘的工作,使备份速度变得更快,不必再担心在磁带驱动器和磁带库上产生的机械故障,并且使文件恢复变得更加轻松。

但是今天,我们的磁盘备份设备的容量已经趋于饱和,在数据中心已经没有足够的空间来备份PT级的数据,在这种情况下,当我们希望将备份数据保存一个月时,却只能保存两到三天。

问题是在我们的备份设备中有太多的重复数据。

现在终于有了解决这个问题的办法,善于抓住机会赚钱的厂商们声称他们的新一代“删除重复数据”产品可以按20:1,甚至300:1的比例缩减我们需要存储的数据量。

果真如此吗?让我们仔细看看。

重复数据删除技术支持在已有的磁盘设备上存储更多的备份数据。

因此采用“重复数据删除”技术可以增加您保存备份数据的时间,减少数据中心的消耗,降低成本。

如果您删除重复数据后再通过WAN发送,那么您就能够节省大量的带宽,并且可以取代磁带实现网上离线备份。

重复数据删除技术唯一的缺点是备份速度变慢。

Inline在线重复数据删除的方式会使用备份服务器的资源,导致备份速度变慢,备份窗口变大。

Post-processing后处理的方式,备份数据流写入到重删设备后重删开始进行,不会影响到备份速度。

还没有评论,来说两句吧...